自动驾驶会导致AI“奇点”后的失控吗?

7月4日,李彦宏在百度AI开发者大会上实现了“吹过的牛B”,L4级自动驾驶商用车阿波龙的商业化量产,成为自动驾驶领域最新的重磅新闻。

同时发布的还有AI芯片“昆仑”,李彦宏也对“昆仑”不惜溢美之词,声称其能在100W的功耗上实现260Tops性能(1Tops=1012次/秒运算)。

可以预见,无论被视为一套系统的自动驾驶技术,还是其中作为“驾驶员”这个关键决策角色的AI技术,将以超出公众想象的速度快速迭代进化。

但随着自动驾驶技术的逐步成熟和商业化应用,其背后人工智能技术的快速迭代,也引起更多对未来的担忧和伦理探讨。毕竟在高速行驶的汽车上,一旦面对最糟糕的结果选择,人类并不信任机器能做出合适的判断。

推理至上与快速迭代

众所周知,L4级被视为自动驾驶的一个关键节点,AI全面接管驾驶工作,人类对驾驶行为的干预不再是必须而实时的。

昆仑芯片在自动驾驶场景中,最重要的工作就是根据传感器数据,满足训练和推断的需求,根据路况不断预测未来0.1-10秒的路面局势变化,这是高等级自动驾驶独特的能力。

换言之,只有经过训练的强AI才能独立处理未知局势。

例如谷歌的AlphaGo,在CPU之外采用了用于评估局面的4TPU。实际上是卷积神经网络的应用。它的分支有两个:价值和策略。不必每一步都穷举到最后,它就能推断每一步的价值和对最终获胜的影响。

按照谷歌首席工程师的说法,在任何一步,AlphaGo都会准确预测如何能赢。

这不是在跳大神,而是自我监督下的AI展现出强大的推理和预测能力。如果采用云端算法,很可能实现强AI。

仅仅过了一年时间,战胜过李世石和柯洁的AlphaGo,已经没有任何一个活着的人类可以匹敌了。它拥有40层神经网络和“足够视野的前瞻性”,能够看到未来的危险和价值,并采取最优策略。

尽管因为应用场景只局限于园区等固定区域,阿波龙的L4级自动驾驶仍有争议,但在开放道路上的L4级自动驾驶,强化AI是其中最可能的途径。它可以避免优步在今年早些时候、在凤凰城路测发生的悲剧。

此前,在量产车上搭载的行车电脑ECU(包含微处理器、外围电路、存储器和接口等)可以做之前人类才能做的事。

在它的指挥下,自动变速箱通过液力变矩器调整传动比,轻松换挡。而转向机构则会感知方向盘的动作,产生助力。在高速行驶中遇到变道行驶或侧风、路面倾斜等外部干扰时,驾驶人可以自如操纵方向。低速转弯时前后轮转动方向相反,可以轻松通过以前需要多次转弯才能通过的小弯。

尽管现在ECU能做这么聪明的事,但它仍然不被看做AI。因为真正的AI核心在于推理能力,这一点也正以肉眼可见的速度飞快迭代和进化,就像AlphaGo每晚与自己对弈数百万盘,而人类通常在睡大觉。

如何满足不知满足的人类呢?AI需要超越现有人类认知水平和能力,如同围棋比赛中那样,被惊倒的人们自然将王冠奉上,并日益依赖更聪明的AI。

通用AI的再进化

如果计算机有情感,它会发现人类的推理能力实在是弱爆了。逻辑的层级和旁路拓展多到一定地步,人类就无法记住众多的信息和它们彼此的关联,更别提放在一起分析了。

但人类也有AI无法企及的地方,人类的直觉值得肃然起敬,并善于将复杂问题简化,然后用直观判断的方式直趋答案。隐藏的信息是否足以支持做出精准的判断?虽然不总是正确,但这样耗费的时间和精力都是可接受的。我们放弃了一些表象,捕捉隐含信息(学术上称为“次表征”),从而追求更快地解决问题。

人们期待计算机的“思考”方式能够模拟大脑结构。但是,无论谷歌的TPU,还是百度的昆仑,都只能针对限定输入给出结论。

如果围棋的棋盘变成20×19,人类棋手稳赢,而AlphaGo则可能不知所措。如果道路标线模糊不清,AI可能选择让汽车停下来,而人类驾驶员则可以大致“循迹”行驶,基本不受影响。

那么如何让计算机看起来不那么蠢呢?

人类需要的是“通用AI(General AI)”,可以下棋、聊天、认识朋友、开车。人类可能很难猜到它下一步将会如何,就像很难洞察另一个人类一样。但它的行为,按照人类行为准则,一定是明智、合理的。

这样的AI必然立足于“机器学习”。本地算法无法涵盖所有路况,设计者必须赋予无人驾驶系统一定的自主权,避免在特殊路况下该系统不知所措。和人类一样,计算机仍然要先搜集大量数据样本,也就是各种路况下的驾驶行为,就像人类也需要反复练习驾驶技能,锻炼预见性和形成固定的肌肉记忆。

机器学习,实际上是将人类学习过程“外化”。选择合适的模型,让模型学习样本,从而找出数据的内在规律,从而形成对未知路况的“经验”。

面对复杂外界条件,AI仍然需要基本的预设应对策略。在人类无法厘清复杂的因果关系时,不需要也无法为AI设立先决条件和成熟策略。事实证明,机器学习,更善于从海量数据中抽象出若干有价值的因素,同时确定因素之间的相关性。从而确立应对策略。

比如,在城市快速路上行驶的驾驶员,主观上对突然出现的行人缺乏预期,因为法律上禁止行人穿行。AI也同样很难从样本中学到,如何在封闭道路上应对突然出现的障碍。

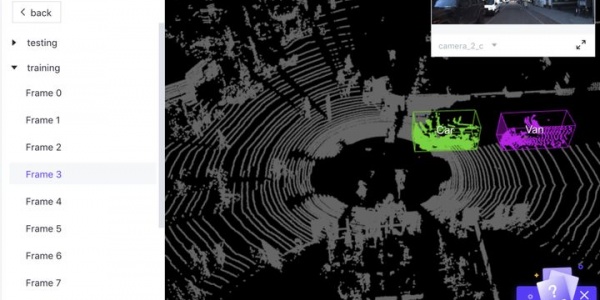

这也就是“逾规则”状态下的应对能力。理论上,自动驾驶系统的传感器(比如激光雷达)可以比人类驾驶员更早地发现违规行人,即环境感知。

假设行人采取不明智的做法,如加速奔跑、快速从车前穿行等。人类驾驶员如果发现刹车距离不够,将面临两难,如果直接将刹车踩到底,有很大概率发生碰撞;如果一边变线一边刹车,很可能与同向车辆发生碰撞,引发更严重的事故。而观察相邻车道的情况则导致更多的时间延迟,这种情况下,人类很难做出最佳选择。

AI系统则会对行人行为模式建立模型,根据其肢体动作,预估其下一步的位置,同时收集相邻车道和交通标志线信息。在20ms内计算出,多少转向力度和刹车力,才能保证自身安全和避免碰撞,即决策协同。

最后的动作,则驱动车辆完全实现此前的计算,即控制执行。

其中的核心在于预估对方的行为。只有“强AI”才有可能做到这一点。赋权不够或者学习能力不足的本地计算机,将无法胜任。这也是未来的无人驾驶系统必然是“强AI”的原因,虽然这个概念备受争议。

未知导致恐惧

但由此带来的问题是,在汽车自动驾驶这个关于人类生命安全的应用场景中,如果交通网络完全由无人驾驶车辆组成,AI本身将形成另一套交通规则,无须而且排斥人类的参与。

比如,人类驾驶车辆在时速120公里时,通常要保持100米以上间距。而无人驾驶车辆则可以形成紧密的车队,以减少风阻,间距可以减少到数米,时速则可以提升到200公里以上。同时,一辆车所见的场景,也会被其他车辆所见。它们的感官由于高速通讯而得到延伸。

这样的强AI应用场景一旦实现,人类将陷入更深的担忧。因为其强大的学习能力,自我进化速度极快,很可能产生自我意识,不愿意被人类束缚。而人类对其思维和执行缺乏预见,一旦失控,相比于人类驾驶的场景,后果更加是灾难性的。

无知导致恐惧,即便可以执行完全无害的任务,也会因为不可预知性而让人类害怕。因为强AI的决策过程,基本上是个“黑盒子”。

马斯克和今年去世的霍金都曾发出严厉警告,强AI实现之日,被称为“奇点”,可能会导致凯文·凯利所称的“失控”。

马斯克还举过一个例子,“比如你创建了一个可以自我完善的AI来摘草莓,这个AI可以干得越来越好,摘得越来越多。不过,这个系统想做的事情就是摘草莓,所以它可能会把全世界都变成草莓园,永远都是草莓园。”

这也是被视为科学前瞻的科幻小说中,几乎永远对人工智能表达出忧患意识甚至末日情绪的根本来源。

但在现实中,面对AI可能的自我意识觉醒,拉里·佩奇表示并不担心,他认为AI的善恶取决于创造者,眼下的科技公司们仍然普遍致力于增强型AI的研究。

毫无疑问,自动驾驶的终极解决方案是强AI,但有远见的学者都对此表示强烈的担忧。这是否意味着我们应该在此之前“踩刹车”或者另辟蹊径?一条风景极佳的道路尽头是否深渊?

最糟糕的预期,很可能来自我们恐惧的源头——人类从未面对过比自己更聪明的实体。

从上帝视角来看,我们是否正不遗余力地奔向悬崖?强AI能解决自动驾驶场景的诱惑,让我们无暇顾忌可怕的后果。实在不行,拔掉电源插头总可以吧?

基于过去的经验,没有任何一台机器可以在人类理智时作乱。但眼见着AI一天比一天强大,它在解决困扰人类上百年的交通问题的时候,会不会带来一系列更大的麻烦?

至少眼下,没人能回答这个问题。无论承认或者否认,都无法预测AI的进化速度是否始终受控。

广告

广告 最新资讯

-

使用 HEADlab 测量电流

2026-01-23 17:13

-

奇石乐持续推进全球碳中和战略

2026-01-23 16:47

-

吉利汽车,新公司落户湖北!

2026-01-23 16:12

-

直播|车载光通信技术路线及测试挑战

2026-01-23 13:05

-

重磅!工信部明确新车准入须开展30000km可

2026-01-23 13:05

广告

广告