直接策略学习简介:基于BC的自我优化学习方法

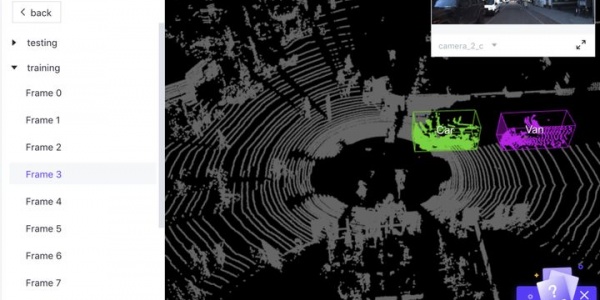

直接策略学习(DPL)是一种基于行为克隆(BC)的深度强化学习方法,它可以通过自我优化来评估当前策略并获得更适合的训练数据。相比于BC,DPL的主要优势在于利用专家轨迹来指导代理如何从当前错误中恢复。通过这种方式,DPL可以缓解由于数据不足而造成的BC限制,从而在强化学习任务中取得更好的效果。

在DPL的研究中,经典的在线模仿学习方法是数据集聚合(DAgger)。DAgger是一种主动学习方法,它通过修改代理所经历的所有状态-动作对的主分类器或回归器,来解决序列预测问题。然而,DAgger的学习效率可能会受到策略空间和学习空间之间距离过大的抑制。为了解决这个问题,He等人提出了一种名为“DAgger by coaching”的算法。该算法使用教练演示易于学习的策略,并且演示的策略逐渐收敛到标签,从而更好地指导代理。为了构建折衷策略,教练会建立一个不比地面实况控制信号差的策略,并比新手预测的行动要好得多。

尽管DAgger是一种经典的在线模仿学习方法,但研究人员指出了它的一些缺点,如查询效率低、数据收集器不准确和泛化能力差。为了解决这些问题,Zhang等人提出了SafeDAgger算法,旨在提高DAgger的查询效率,并可以进一步减少对标签准确性的依赖。Hoque等人提出了一个ThriftyDAgger模型,该模型集成了人类对角落情况的反馈。Yan等人提出了一种新的无地图场景下导航任务的DPL训练方案,这两种方案都提高了模型的泛化能力和鲁棒性。

除了在模仿学习中应用DPL,它还可以用于微调感知到行动方法中的代理策略。例如,Ohn-Bar等人提出了一种优化情景驾驶策略的方法,该方法可以有效地捕捉不同场景中的推理。训练分为三个部分:首先通过BC方法学习次优策略,其次训练上下文嵌入来学习场景特征,最后通过与仿真的在线交互来完善集成模型,并通过基于DAgger的方法收集更好的数据。这种方法可以在真实世界中提高驾驶的安全性和效率。

DPL的一个重要应用领域是机器人学习。在机器人领域,DPL可以用于机器人的自主导航和控制。例如,在Yan等人的研究中,他们提出了一种基于无地图的DPL方法,可以帮助机器人在未知环境中进行导航。他们使用深度卷积神经网络(CNN)来表示机器人感知到的图像,并将其与LSTM模型相结合,以捕捉机器人的历史轨迹和动作。他们还使用DAgger方法来改进模型,从而在未知环境中实现更好的导航性能。

在DPL的实际应用中,一些挑战需要被克服。首先,DPL需要大量的训练数据来优化策略。然而,数据采集可能会导致机器人在现实世界中表现不佳,从而使得数据收集变得更加困难。其次,DPL的学习过程需要时间,可能需要数百万次的训练迭代才能得到较好的效果。这需要高性能的计算硬件和算法的优化。此外,DPL算法的鲁棒性和泛化能力也是需要解决的问题,因为模型可能会受到环境变化和噪声的影响。

总之,直接策略学习是一种强大的深度强化学习方法,可以用于机器人学习、自主导航和控制等应用领域。虽然DPL存在一些挑战,但研究人员已经提出了一系列改进方法,包括DAgger by coaching、SafeDAgger、ThriftyDAgger和无地图DPL方法等。这些方法可以提高DPL算法的性能、泛化能力和鲁棒性,从而使其更适用于实际应用中。

- 下一篇:反向强化学习(IRL)的三种方法

- 上一篇:行为克隆:自动驾驶中的主要学习方法

广告

广告 最新资讯

-

整车性能测试体系:汽车试验工程的基本框架

2026-03-10 12:54

-

联合国法规R76对轻便摩托车前照灯远近光性

2026-03-10 12:15

-

联合国法规R75对摩托车与轻便摩托车气压轮

2026-03-10 12:14

-

联合国法规R74对L1类车辆灯光与光信号装置

2026-03-10 12:14

-

联合国法规R73对货车侧面防护装置的工程化

2026-03-09 12:14

广告

广告